L’intelligenza artificiale (IA) è tutto quello che concerne la simulazione o mimesi dell’intelligenza umana al fine di eseguire funzioni o attività simili agli esseri umani. Una delle principali caratteristiche dell’IA è la sua abilità a definire azioni sulla base della loro probabilità al fine di raggiungere determinati obiettivi nel modo migliore possibile. A oggi, l’intelligenza artificiale rappresenta il più grande concept nella creazione di macchine intelligenti che possono simulare la capacità pensante e il comportamento dell’essere umano.

Non c’è da stupirsi che oggi l’intelligenza artificiale è quindi diventata popolare e diffusa in una sconfinata serie di settori: da quello finanziario, all’automotive, dalla supply chain, alla salute, dalla formazione, alle reti di comunicazioni e telefonia e così via; ultimo, ma non per ultimo, il settore agroalimentare, che con l’impiego di piattaforme digitali, sistemi IoT (Internet of Things), droni, robot (tra cui i farmbot), sarà foriero di tante novità a riguardo, nel breve-medio periodo.

I settori dell’IA applicati in campo

Nel grande tema dell’intelligenza artificiale confluiscono diversi settori e/o subaree che ne fanno parte. Di seguito le principali:

- Machine learning (ML o apprendimento automatico): è una componente dell’IA che fornisce intelligenza alle macchine in modo tale che queste possano imparare automaticamente attraverso le esperienze vissute, senza essere state espressamente programmate per farlo all’origine. È a oggi il più diffuso e comune approccio di IA nel settore agricolo e agroalimentare.

Il machine learning rappresenta un tassello fondamentale dell’agricoltura 5.0, in quanto può migliorare le rese, contribuire a ridurre i costi (minimizzando perdite e rischi), prevedendo condizioni sfavorevoli come eventi meteorologici avversi. Gli algoritmi di intelligenza artificiale interpretano e analizzano gli input così come gli output, cosicché il modello di macchina affini la sua precisione con il progredire del tempo.

- Deep learning (DL o apprendimento approfondito): è un sotto raggruppamento sia dell’IA sia del ML e permette alle macchine di eseguire compiti e operazioni simili a quelli umani, escludendo però il coinvolgimento diretto degli esseri umani. Il DL abilita i dispositivi di intelligenza artificiale a imitare ovvero simulare l’attività del cervello umano come reti neurali artificiali (artificial neural network, Ann).

Ambiti di utilizzo

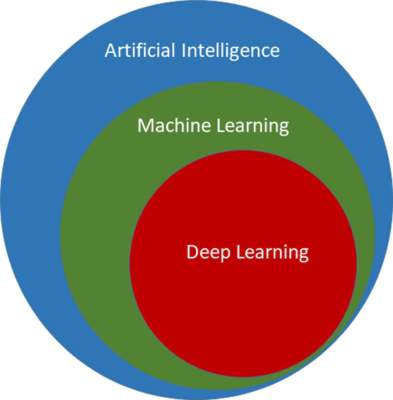

Il machine learning e il deep learning (tra cui le reti neurali artificiali) sono settori strettamente interconnessi tra loro all’interno dell’IA (fig. 1).

Ecco alcuni ambiti di applicazione che si basano sulle conoscenze sia del ML sia del DL:

- Natural language processing (NLP o elaborazione del linguaggio naturale): consente a un sistema informatico (solitamente un computer) di comprendere ed elaborare il linguaggio umano sia come testo sia come discorso. Con tale sistema, il linguaggio umano può essere impiegato per progettare macchine che imparano e lavorano. È gia comunemente impiegato nel settore informatico e nell’automotive (comandi vocali, Alexa, Siri, Cortana, Google ecc.)

- Robotics (robotica e, più recentemente, robotica collaborativa): è oggi un settore di grande interesse e in forte espansione. È incentrata prevalentemente sulla progettazione e sviluppo di robot (tra cui i famosi “farmbot”, impiegabili nel settore agroalimentare). La robotica è un settore scientifico interdisciplinare che contempla discipline quali ingegneria meccanica, elettronica, informatica ma anche psicologia dell’intelligenza artificiale ecc.

- Machine vision (MV o visione artificiale): è un’applicazione della visione computerizzata e permette alle macchine di riconoscere gli oggetti. Questa tecnica intercetta ed analizza l’informazione visiva (spesso da immagini o video o conversazioni), impiegando ona o più foto/videocamere. Tale sistema è programmato per effettuare compiti puntualmente definiti come il conteggio di oggetti, lettura di numeri di serie ecc. Tuttavia, la visione artificiale non può essere considerata allo stesso modo dell’occhio umano, perché questa non è vincolata dalle limitazioni umane e inoltre è dotata della capacità di vedere anche attraverso barriere fisiche.

Reti neurali artificiali: la nuova frontiera

Circa 86 miliardi di neuroni e un numero pressoché sconfinato di connessioni costituiscono il cervello umano nel formare le reti neurali naturali (o biologiche). Ma proprio a queste fitte organizzazioni cellulari l’uomo si è ispirato per ideare qualcosa di simile: le reti neurali artificiali.

Inizialmente, le reti neurali artificiali (Ann o artificial neural networks) sono state pensate per risolvere ovvero gestire problemi alla pari di quello che può fare il cervello umano. Nello specifico, le reti neurali artificiali sono strumenti del machine learning che cercano di simulare le funzioni del cervello umano svolgendo funzioni complesse quali ragionamento, logica, apprendimento e memoria, calcoli computazionali e processi decisionali. Una Ann permette di sviluppare delle interrelazioni tra settori informativi anche molto distanti e differenti fra loro. A livello tecnico, esistono due tipologie di Ann: quelle semplici (traditional Ann) e quelle complesse (deep Ann).

Come sono fatte

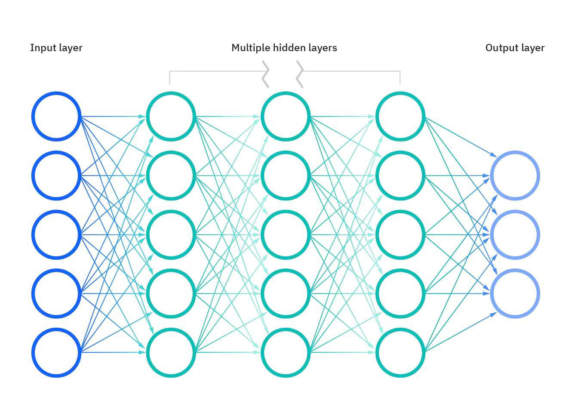

Le reti neurali semplici sono costituite da nodi o unità (chiamati “neuroni artificiali”) che sono connessi l’un l’altro da una rete e le connessioni tra i singoli neuroni sono chiamati ponti sinaptici (molto simili alle sinapsi dei mammiferi). Costitutivamente, una rete neurale semplice è composta da diversi strati informativi (o layers): uno strato di ingresso (input layer), uno strato nascosto (hidden layers, dove ha luogo il vero e proprio apprendimento), e lo strato di uscita (output layer), come illustrato in fig. 2. Dall’altra parte invece esistono le reti artificiali complesse costituite in questo caso da una presenza di più strati nascosti (hidden layers), come rappresentato in fig. 2.

In vari ambiti questi modelli stanno fornendo risultati che si avvicinano sempre più alle capacità dell’essere umano (e non possiamo nemmeno scientemente escludere che in futuro potranno anche essere superiori).

Numerosi e svariati gli ambiti di impiego nel settore agroalimentare: analisi di dati, internet of things (IoT), processi di automazione, tecniche colturali, sistemi di processamento, monitoraggio delle colture.

I vantaggi in agricoltura

L’intelligenza artificiale svolge un ruolo essenziale nell’agricoltura 4.0 (e ancor più nella emergente 5.0). Numerosi sono i vantaggi che essa può generare. Tra i tanti, l’intelligenza artificiale può:

- supportare efficacemente nella raccolta e nell’interpretazione dei dati ottenuti sul campo, favorendo quindi un impiego adeguato e sostenibile delle risorse e/o dei mezzi tecnici;

- aiutare nel realizzare modelli predittivi precisi e accurati sulla base dei dati raccolti;

- individuare, mediante impiego di appositi modelli, l’insorgenza di agenti di malattia e/o di danno, quindi migliorare la qualità delle produzioni e contenere le perdite;

- rivestire un ruolo strategico nell’interpretazione e supporto nella previsione di eventi agrometeorologici;

- essere impiegata da agricoltori e tecnici per valorizzare il business aziendale, con migliore efficientamento di tempo e risorse;

- aiutare, unitamente con la gestione dei big data, nel mitigare pericoli di natura ambientale e quindi ridurre il degrado e lo sfruttamento ambientale;

- rappresentare uno strumento valido per efficientare processi (ad esempio attività di coltivazione, raccolta, operazioni fitosanitarie ecc.) al fine di migliorare il benessere e auspicabilmente, la salute e la sicurezza nei luoghi di lavoro.

Nella pratica, le operazioni che oggi si avvalgono dell’intelligenza artificiale e del machine learning sono in continuo crescendo e fra queste si ricordano le attività di gestione dei suoli, sistemi irrigazione smart, previsioni agrometeorologiche, l’impiego di sistemi a pilotaggio remoto (tra cui i droni), farmbot, veicoli a guida autonoma, traffico controllato, blockchain, sistemi di monitoraggio evoluto delle colture e delle avversità e molto altro.

Collaborazione, non competizione

Queste applicazioni stanno riscuotendo un’importanza crescente nelle filiere agroalimentari, al fine di assicurare un migliore presidio ed efficientamento delle diverse attività e al contempo semplificare le operazioni svolte dell’uomo, possibilmente anche in termini di impegno fisico. È quindi auspicabile una crescente (e migliore) collaborazione tra gli strumenti di automazione, le macchine, i robot e l’essere umano, che quindi non deve essere mai vista in termini competitivi quanto piuttosto mutualistici, di supporto reciproco (co-working).

Come e quanto questi sistemi potranno ancora svilupparsi nel prossimo futuro non è possibile prevederlo, anche se le aspettative sono molte.

In fondo però, già nel 2006, la grande neuroscienziata e Premio Nobel, professoressa Rita Levi-Montalcini, affermava: «Dati gli enormi progressi in atto nelle scienze dell’intelligenza artificiale, ci si pone la domanda se anche negli elaboratori e nelle macchine possa verificarsi, come è già avvenuto nel cervello umano, un’evoluzione di tipo “naturale” darwiniana che li renda in possesso anche di capacità creative ed etiche». Una straordinaria lungimiranza e visione verso un futuro ricco di attese e di innumerevoli sfide.

Una rivoluzione nata nel Novecento

Le origini del termine “intelligenza artificiale” risalgono fin dai tempi della filosofia classica, quando si descriveva il pensiero dell’uomo per interpretare i simboli.

In realtà, il termine fu coniato per la prima volta nel 1956 alla conferenza di Dartmouth dallo scienziato americano John McCarthy, che la definì come “la scienza e l’ingegneria del progettare macchine intelligenti”.

Nei primi anni ’50, l’ormai oggi famoso problem solving (gestione dei problemi e ricerca delle soluzioni) fu una delle prime aree di ricerca dell’IA.

Negli anni ’60, poi, il dipartimento della difesa americana iniziò a interessarsi a computer che simulassero – quasi emulandolo – il comportamento umano. Da qui nacquero diversi tentativi verso l’automazione e il perfezionamento di elaboratori informatici prima e macchine “intelligenti” poi, che potessero in qualche modo incorporare i modelli di comportamento e interazione umana.

Dagli anni 2000, la rivoluzione dell’intelligenza artificiale incominciò a essere presente anche nelle abitazioni civili e per usi privati.